Los robots de metaetiquetas debe colocarse en todas las páginas y tiene el propósito de dar información a la araña para indicar qué páginas indexar y cuáles deben omitirse.

Esta es su sintaxis:

- le dice a la araña que archive la página en la base de datos ÍNDICE

- NOINDEX le dice a la araña que no almacene la página en la base de datos

- SEGUIR dile a la araña que siga los enlaces de la página

- NO SEGUIR dile a la araña que no siga los enlaces de la página

La etiqueta robots debe insertarse en el contenido de la grupo, entre las etiquetas Y página como en este ejemplo:

El título de la página El contenido de su página web.

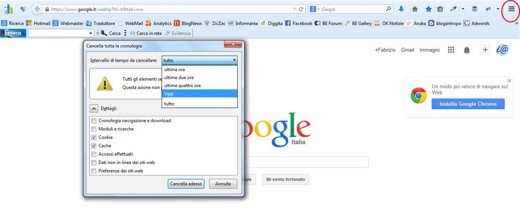

Google agrega el contenido de las páginas indexadas a su base de datos mientras navega por las páginas. El contenido guardado se llama versión cache, y se puede ver haciendo clic en el enlace Contenido cache. Si no desea que el contenido se guarde en la base de datos de Google, use esta etiqueta:

Esto no evitará que Google indexe su página, solo evita guardar contenido que puede resultarle inapropiado presentar en versiones desactualizadas. Si no desea indexar la página, deberá utilizar la etiqueta "noindex".

Otra alternativa al procedimiento anterior es comunicarse de manera específica con Google Spider u otro agente. Esto permitirá que los otros motores almacenen los datos, pero no Google.

Il archivo robots.txt Debe insertarse en la raíz del sitio y está compuesto por:

Agente de usuario:

Disallow:

En el campo User-agent tienes que poner el nombre de la araña. Con el símbolo * te refieres a todas las arañas.

En el campo Disallow: dirás lo que no quieres que la araña se retire. Por ejemplo, dígale a Google que no obtenga el archivo soultricks.htm.

- Usuario-agente: googlebot

- No permitir: /soultricks.htm

Ejemplo de registro:

Usuario-agente: googlebot

No permitir: /testi.html

No permitir: / poemas /

El registro antes mencionado le dice a Google ("googlebot" es el nombre de la araña de Google) que no está permitido descargar el archivo text.html o acceder al directorio "poems" y su contenido, incluidos los subdirectorios. Observe cómo el nombre del archivo está precedido por un carácter "/" (que indica el directorio raíz del sitio) y cómo el nombre del directorio también usa un carácter "/" al final.

El campo Agente de usuario puede contener un asterisco "*", Sinónimo de "cualquier araña". Entonces, el siguiente ejemplo le dice a todas las arañas que no busquen el archivo temporal.html:

User-agent: *

No permitir: /temporaneo.html

El campo rechazar puede contener un carácter "/" para indicar "cualquier archivo y directorio". El siguiente ejemplo evita que un scooter (la araña de Altavista) recoja algo:

Agente de usuario: scooter

No permitir: /

Por último, el campo No permitir se puede dejar en blanco, lo que indica que no hay archivos o directorios que desee evitar que se recojan. El siguiente ejemplo muestra cómo decirle a todos los motores de búsqueda que busquen todos los archivos del sitio:

User-agent: *

Disallow:

Ejemplo de un archivo robots.txt

El archivo robots.txt se compone de uno o más registros, cada uno de los cuales examina diferentes arañas. Así que aquí hay un ejemplo completo de archivo robots.txt, que bloquea completamente Altavista, previene Google acceder a algunos archivos y directorios y dejar libre acceso a todos los demás motores de búsqueda.

Agente de usuario: scooter

No permitir: /

Usuario-agente: googlebot

No permitir: /intestazione.html

No permitir: /links.html

No permitir: / temporal /

No permitir: / cgi-bin /

User-agent: *

Disallow:

Aquí está la lista de algunas arañas.

Motor de búsqueda de araña

========================

googlebot Google

rápido Rápido - Alltheweb

slurp Inktomi - Yahoo!

Scooter altavista

mercator Altavista

Pregúntale a Jeeves Pregúntale a Jeeves

teoma_agent Teoma

ia_archiver Alexa - Archivo de Internet